|

Volumen 16 - Nº 95 Octubre-Noviembre 2006 |

|

Volumen 16 - Nº 95 Octubre-Noviembre 2006 |

|

|

|

|

|

|

|

En el caso de las letras, probablemente ninguna más, pero percibiría variaciones en la temperatura del papel si sus ojos extendiesen su rango hasta, digamos, el infrarrojo. De la misma forma, la representación de un objeto permite descubrir o resaltar propiedades invisibles en otras representaciones. ¿Cuál es la representación adecuada para reconocer cierta propiedad de un objeto? Esa es justamente una de las tareas del procesamiento de señales y, en particular, de un área nueva denominada teoría de ondículas o wavelets (denominación en inglés que conservaremos por el resto del artículo). ¿Qué son las wavelets?, ¿cómo se usan?

Información digitalPara responder las preguntas anteriores debemos tener idea de la estructura de la información digital y su importancia y uso en la tecnología actual.

Usaremos, a modo de ejemplo, el caso de la música producida por una orquesta ejecutando una sinfonía. En primer lugar registramos el sonido a intervalos muy pequeños, un proceso que se conoce con el nombre de muestreo (sampling) de la señal analógica. Luego cuantificamos cada medición asignándole un número entero positivo en un cierto rango, por ejemplo de 0 a 512, en forma proporcional. El número lo elegimos de acuerdo con alguna característica física de la señal como el volumen, el tono, el timbre u otras. El registro sonoro se ha convertido así en una sucesión finita de números dentro de un rango fijo que, al ser convertidos a notación binaria, forman bloques de ceros y unos. Estos bloques agrupados consecutivamente siguiendo el orden temporal en que fueron registrados, forman una cadena que llamamos ‘señal digital’ –por contraposición a la ‘señal analógica’, aquella en la cual la misma característica física se registra en forma continua (por la profundidad de un surco, por ejemplo).

Por supuesto, en este proceso de digitalización se ha perdido información de la señal original debido al muestreo realizado. Sin embargo, si este es suficientemente pequeño, la pérdida de información no es importante (al mirar una película, 24 cuadros son suficientes para cubrir el intervalo de un segundo: lo que pasa entre cada cuadro se pierde).

¿Qué ventaja tiene esta representación numérica? Una estupenda; ahora puede ser procesada por una computadora y esto permite manipular y transformar los datos de formas que no son posibles con la señal analógica. Esto da lugar a aplicaciones que van desde la compresión de la información hasta su extracción parcial, el poder modificarla, eliminar el ruido, transmitirla muy rápidamente e introducir innumerables otros procesos.

En el caso de una imagen la situación es similar. Para una fotografía en blanco y negro el análogo a la música es la luz que refleja una foto cuando se la ilumina. Si la subdividimos en pequeños cuadrados (pixeles), y medimos la intensidad de la luz reflejada en cada uno obtendremos un arreglo bidimensional de números (matriz), que pueden ser cuantificados como en el ejemplo anterior. Una vez convertidos estos valores a un rango fijo, lo que queda de la imagen original es finalmente una matriz de coeficientes enteros positivos (filas y columnas) que constituye la imagen digital. Si el cuadriculado es por ejemplo de 256 x 256 y el rango de los valores elegido va de 0 hasta 255, tendremos finalmente un total de 256 x 256 pixeles, cada uno ocupando ocho lugares de memoria, o bytes –usamos la propiedad que con n dígitos binarios se pueden describir todos los números enteros entre 0 y 2n-1. De esta manera representamos la imagen utilizando aproximadamente 65 kilobytes (kB).

| Un

mundo digital

La palabra digital se incorporó al lenguaje diario. Se habla de cámaras digitales, teléfonos digitales, megapixeles, ancho de banda. La digitalización de la información viene acompañada de la posibilidad y necesidad de transformación y procesamiento de esta información, con grandes beneficios. Esta transformación y procesamiento de la información requiere de modelos matemáticos sofisticados que justifiquen y fundamenten las técnicas usadas. Analicemos un ejemplo. Cuando se toma una fotografía con una cámara digital moderna un sensor interno en la cámara registra la imagen convirtiéndola en millones de ceros y unos. Esta información en estado crudo es prácticamente inmanejable. Técnicas de compresión digital basadas en métodos matemáticos complejos y abstractos permiten reducir casi instantáneamente esta fotografía a un tamaño adecuado y almacenarla en la tarjeta de memoria de la máquina sin demasiada pérdida de calidad visual. Al momento de querer ver la fotografía la imagen es reconstruida inmediatamente al tamaño original. Todos estos procesos se realizan internamente en diminutos circuitos (chips) de nuestra cámara. |

Si queremos una imagen digital de más resolución podemos achicar el cuadriculado y/o aumentar el rango de los valores en cada pixel. Por ejemplo si subdividimos cada cuadrado en nuestro cuadriculado original en cuatro, esto nos dará una imagen de 512 x 512 pixeles. Si para el rango de valores que puede tomar cada pixel se permite hasta 16 dígitos en binario (dos bytes), esto aumenta la precisión en la escala de grises de 256 tonalidades a 65.536, lo que dará mayor definición a un alto costo de memoria. Esta nueva imagen ocupará ahora 524 kB. Nuevamente, la señal original ha sido representada por un conjunto de ceros y unos formando una imagen digital.

Igual que en el ejemplo de la señal sonora, en el caso de imágenes digitales, el campo de aplicaciones y las posibilidades de procesamiento son inimaginables.

La extraordinaria capacidad de manipulación que es posible con la información en forma digital, plantea un magnífico desafío intelectual, que consiste en tratar de imitar en una computadora procesos cerebrales que se producen en, por ejemplo, la visión y la audición.

¿Puede una computadora reconocer en una fotografía digitalizada de un grupo de personas, a alguien cuya foto tiene almacenada en su base de datos? Este proceso que cualquier ser humano puede realizar sin dificultad y casi instantáneamente, no es posible hoy llevarlo a cabo en una máquina en forma eficiente.

¿Se puede transcribir música automáticamente? O sea, si se alimenta una computadora con una señal musical sonora digitalizada, ¿puede un programa descubrir los tonos y transcribir la pieza en un pentagrama? Esto tampoco es posible todavía, pero se lograron promisorios avances en la investigación actual.

Estos son solo algunos ejemplos de la clase de problemas que permite atacar la digitalización de la información y que constituyen una fructífera guía para la investigación futura. La velocidad de proceso y capacidad de almacenamiento no parecen ser la clave del problema. La dificultad reside más bien en nuestra ignorancia sobre los procesos en la corteza cerebral. Así desde el punto de vista matemático el desafío es extraordinario. Nuevas aplicaciones requieren teorías nuevas y algoritmos sofisticados que puedan ser utilizados para modelar estos fenómenos. Es aquí donde la teoría de wavelets y sus derivaciones desempeñan un rol fundamental.

|

|

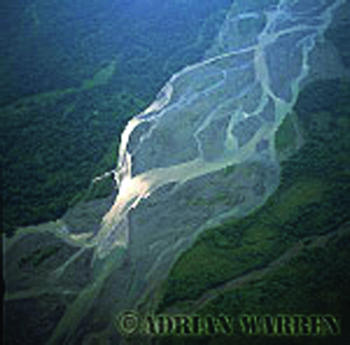

| Figura 1. Una imagen (correspondiente a una fotografía de la colección de Adrian Warren) con distintos tamaños de subdivisiones. A la derecha se muestra la fotografía aérea de un río. A la izquierda, los valores de los pixeles se han promediado para obtener una imagen de menor resolución. Se pierden detalles pero la imagen puede ser almacenada en mucho menos espacio. | |

Un antecedente. Fourier y su análisis de señales

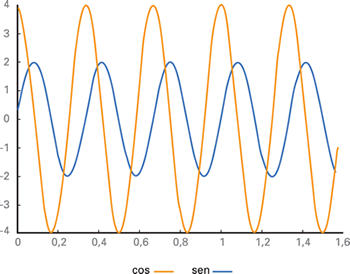

Figura 2. Gráfico de las funciones 2sen(2p.3t) y 4cos(2p.3t). Se multiplicó por 2p el argumento de las funciones para mostrar que ambas oscilan tres veces en el intervalo [0,1]. |

Hace 182 años un matemático francés, el barón Jean Baptiste-Joseph Fourier publicó el tratado Teoría analítica del calor, donde sentó las bases del hoy llamado ‘análisis armónico’ o también ‘análisis de Fourier’. Fourier descubrió que fenómenos complejos pueden ser descompuestos en componentes muy simples, como las funciones trigonométricas ‘seno’ y ‘coseno’, de distinta amplitud y frecuencia. Las funciones 2sen(3t) y 4cos(3t), por ejemplo, dependen de la variable t y sus gráficas son sinusoides que oscilan 3 veces cada vez que t va de 0 a 2p; sus amplitudes son 2 y 4 respectivamente. Se trata de funciones periódicas en el sentido que sus valores se repiten en cada intervalo de longitud 2p (figura 2).

Si ahora consideramos para cada número n las funciones cos(nt) y sen(nt) cada una oscilando n-veces en el mismo intervalo, obtenemos una familia o sistema infinito de funciones, conocido como el sistema trigonométrico. Lo que Fourier notó es que la mayoría de las señales que representan fenómenos periódicos son combinaciones de estas funciones elementales donde cada una estará afectada por un coeficiente que modifica su amplitud. La sucesión de estos coeficientes es lo que se conoce como la transformada de Fourier de la señal. Esta idea de descomponer objetos complejos en otros más simples ha sido muy fructífera en matemática y se la ha empleado con éxito en las más diversas áreas (considérese, por ejemplo, la factorización de números enteros en números primos o indescomponibles muy usada actualmente en criptografía).

El análisis de Fourier se extiende además a señales no periódicas usando sinusoides de frecuencia no entera, o sea de la forma awcos(wt) y bwsen(wt) donde w no necesariamente es un entero. Sin entrar en detalles técnicos y ejemplos artificiales, pensemos que nuestras señales puedan ser descompuestas como superposición de senos y cosenos de distintas amplitudes y frecuencias.

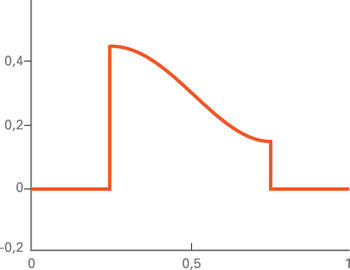

Ahora bien, si el fenómeno que se quiere estudiar es periódico, esta representación es muy eficiente y adecuada. Sin embargo, si gran parte de las señales a considerar en una aplicación no presenta esta propiedad de periodicidad, el uso del análisis de Fourier se vuelve inapropiado e ineficiente. Es muy común que la información relevante en una señal tenga más que ver con los cambios repentinos o discontinuidades que con las partes suaves y no oscilantes. La entrada de un violín en la ejecución de una sinfonía, los cambios repentinos de color en una fotografía, las discontinuidades en un registro de voz, son todos ejemplos de señales ‘transientes’ o sea señales que aparecen repentinamente y son de corta duración. La descomposición de Fourier para estas discontinuidades requiere de componentes de alta frecuencia, o sea muy oscilantes. Estas componentes no se atenúan y continúan oscilando todo el tiempo, aun donde la señal original es suave. Esto obliga a que la representación precisa de la señal requiera de componentes adicionales que neutralicen estas oscilaciones, lo que redunda en una representación menos eficiente. Como en las aplicaciones se usa una cantidad finita de componentes (truncado de la transformada de Fourier), la representación resulta de pobre calidad (ver figura 3).

|

|

| Figura 3. Errores en la reproducción debido al uso de la transformada de Fourier. En el dibujo de la izquierda se muestra una función con dos discontinuidades. En el dibujo de la derecha la misma función es representada usando un truncado de su transformada de Fourier. Los efectos de las discontinuidades en la aproximación son conocidos como el fenómeno de Gibbs. | |

Es ilustrativo volver al ejemplo de la orquesta ejecutando una sinfonía. Las notas aparecen repentinamente al ser ejecutadas por cada instrumento y van decreciendo en amplitud hasta desaparecer. La partitura especifica para cada nota dónde comienza, cuál es su amplitud y su duración. La descomposición de Fourier, en cambio, corresponde a una escritura usando armónicos puros donde cada nota es ejecutada indefinidamente siempre con la misma amplitud. Como muy bien lo ilustró el norteamericano Gilbert Strang en 1994, si se usara la ‘partitura de Fourier’ la orquesta no necesitaría director y cada músico estaría todo el tiempo ejecutando la nota que le ha tocado en suerte. La partitura y la descomposición de Fourier son dos representaciones diferentes de la misma señal.

El ejemplo anterior muestra la conveniencia de introducir descomposiciones más adaptadas a la estructura de las señales. Una condición que surge es la necesidad de que las funciones base estén localizadas en el tiempo, o sea que comiencen en algún instante, oscilen por un tiempo y luego se desvanezcan. En realidad se puede pedir un poco menos; basta que la mayor parte de su energía esté concentrada o localizada en un intervalo finito de tiempo. Esto permitirá describir comportamientos locales en la señal bajo estudio, sin condicionar la escritura del resto.

Un ejemplo interesante en el cual las señales son localizadas en el tiempo aparece en la exploración petrolera. Para obtener información del subsuelo, se genera una onda en la superficie del terreno a explorar mediante una explosión o una serie de golpes producidos por un pistón gigante. Esta onda inicial, de mucha amplitud y muy concentrada en el tiempo, viaja a través del subsuelo el que, como un filtro, la amortigua y la dilata. Cuando la onda atraviesa una interfase entre dos capas de distinta densidad, parte de ella se refleja con una intensidad que depende de la diferencia de densidades entre las capas. La onda reflejada viaja de vuelta a la superficie donde la registran sensores especiales. Hay una onda reflejada en cada interfase encontrada que ocurre a distintas profundidades y en distintos instantes de tiempo. La señal registrada por los sensores contiene información de las distintas capas; es una superposición de distintas amplitudes de una onda fija dilatada y trasladada en el tiempo. Esta es la información útil que hay que analizar para realizar una correcta prospección.

Este ejemplo muestra un fenómeno común a muchas de las señales que aparecen en las aplicaciones: el proceso de formación determina una estructura que se describe adecuadamente como superposición de señales simples que podríamos denominar átomos, cuya combinación produce la señal compleja. En el análisis de Fourier, los átomos son las sinusoides, o senos y cosenos de distinta frecuencia y amplitud, que se repiten indefinidamente. Ahora presentaremos nuestros nuevos átomos, las wavelets, que son funciones localizadas, oscilantes y cuya amplitud decrece rápidamente.

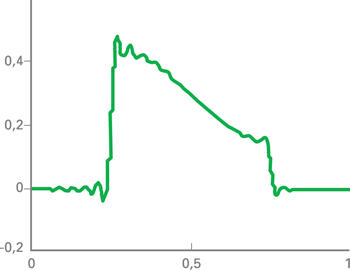

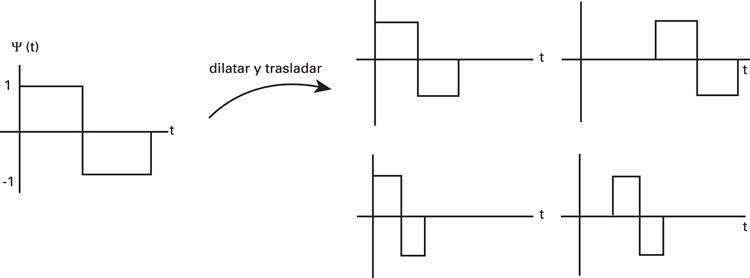

WaveletsIntroducidas en la década de 1980, una wavelet es una función del tiempo w=w(t) de energía finita, oscilante y bien concentrada. Esta función es luego dilatada y trasladada en el tiempo. Estos son nuestros átomos. Por ejemplo, w(2t) dura la mitad del tiempo, mientras que w(t/2) dura el doble. En el primer caso el gráfico de la función se ha contraído (la función está más localizada), mientras que en el segundo caso se ha expandido, o sea, la función está menos concentrada (ver figura 4). Por otro lado, la señal w(t-k) comienza k unidades de tiempo más temprano y aw(t) tiene una amplitud a-veces la de la wavelet original.

Figura 4. Wavelet de Haar a distintas escalas. En la parte izquierda se muestra la wavelet original. A la derecha arriba se ve la wavelet contraída en el tiempo y una traslación de ella. A la derecha y abajo, la misma wavelet más contraída y una traslación. |

En lo que sigue, cuando hablemos de dilataciones de w(t), nos estaremos refiriendo tanto a las expansiones como a las contracciones de w(t).

Un teorema central en la teoría afirma que si nuestra función inicial w es elegida adecuadamente, entonces cada señal de energía finita resulta ser una superposición de estos átomos, cada uno multiplicado por un coeficiente. Esta representación es única, y los coeficientes de la representación conservan la energía de la señal. O sea que se obtiene una representación que imita la estructura de las señales bajo estudio.

Análisis por transformadas| Alberto P Calderón nació en Mendoza, Argentina, en 1920, y luego de cursar sus estudios de ingeniería en la Universidad de Buenos Aires, trabajó en YPF en problemas matemáticos relacionados a prospección petrolera. En 1948, fue descubierto por Antony Zygmund, de la Universidad de Chicago, quien lo invitó a Estados Unidos, donde se graduó de Doctor en Matemática. Su obra se caracteriza por su gran originalidad y profundidad. Sus contribuciones han sido de un espectro muy amplio, y han cambiado la manera en la que piensan y trabajan investigadores en muchas áreas de la matemática y sus aplicaciones. Su influencia fundamental es en el análisis armónico, las ecuaciones diferenciales y el análisis complejo, así como también en procesamiento de imágenes y señales, geofísica y tomografía computada. En 1991, Calderón fue condecorado con la medalla National de la Academia de Ciencias de los Estados Unidos. Falleció en Chicago en 1998. |

Lo que se denomina la transformada wavelet es la representación que asocia a cada señal una sucesión de coeficientes que corresponden a traslaciones y dilataciones de una wavelet original. Con sinusoides como átomos los coeficientes nos daban la transformada de Fourier; ahora tendremos una transformada wavelet. ¿Por qué queremos encontrar estos coeficientes? La idea detrás del análisis por transformadas es que una representación diferente puede resaltar propiedades de nuestro objeto que estaban ocultas en la representación original. En la sinfonía del ejemplo anterior un escrupuloso análisis de la transformada y sus coeficientes asociados nos podrían permitir discernir entre la parte de una viola y la de un chelo en la composición que se registró. La transformada de Fourier y la transformada wavelet permiten estudiar la suavidad o regularidad global de una función a partir del tamaño de sus coeficientes. Otra propiedad que ambas comparten es que en ambos casos existen algoritmos eficientes para calcular la transformada. Esto es crucial al momento de trabajar en aplicaciones concretas. Ambas transformadas son invertibles en el sentido de que cada señal tiene una única representación en términos de sus átomos. En el caso de wavelets, esta es una propiedad central en la teoría que se deduce de un profundo resultado teórico obtenido años antes, en otro contexto, por uno de los matemáticos más brillantes del siglo pasado, el argentino Alberto Calderón.

Hasta aquí las coincidencias, ahora las diferencias. La gran virtud de la transformada wavelet, en contraposición con la de Fourier, es que sus componentes básicos –átomos– están bien localizados. Esto permite estudiar la regularidad de una señal en un intervalo corto de tiempo, considerando solo aquellos coeficientes asociados a ese intervalo. Si una señal, repentinamente y por un lapso breve, presenta severas irregularidades u oscilaciones, su descripción en términos de nuestros átomos requerirá una gran cantidad de componentes localizadas que permitan describir la estructura fina. Solo unos pocos átomos serán necesarios en zonas donde la señal es suave y con poca variación si la wavelet fue elegida adecuadamente. En la descripción completa de una señal habrá más coeficientes donde la señal sea más oscilante o irregular y unos pocos en las partes suaves o de poca variación.

Pensemos por un momento en el ejemplo de una fotografía aérea en blanco y negro. Típicamente aparecerán grandes zonas u objetos con tonalidad constante (por ejemplo un campo sembrado); habrá también objetos más pequeños y por último detalles imperceptibles, todo distribuido en la superficie que ocupa nuestra fotografía. Nuestra wavelet, al ser muy concentrada, ocupará una porción pequeña comparada con la superficie de la imagen. Las dilataciones w(2nt) la concentrarán aún más y las del tipo w(t/2n) la expandirán, ocupando más superficie en la imagen. O sea que contamos con toda una gama de átomos de distinta concentración o localización. Al momento de describir las zonas grandes con la misma tonalidad se usarán las componentes menos localizadas. Las traslaciones permitirán ubicar estas componentes en la zona adecuada. Cuando se describan los objetos pequeños o las zonas con bruscas variaciones de tono usaremos componentes más concentradas. El carácter oscilante de nuestros átomos va a permitir que su superposición describa con exactitud la imagen original.

Nuevamente en este ejemplo aparece la misma propiedad que antes mencionamos. La señal, en este caso la fotografía aérea, no es otra cosa que la proyección de objetos tridimensionales superpuestos sobre un plano. Así nuestra representación en wavelets imita la formación de la imagen.

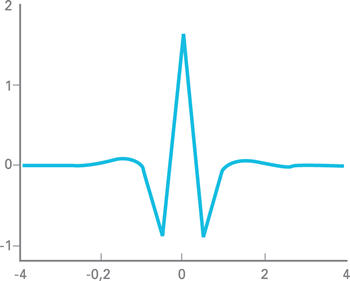

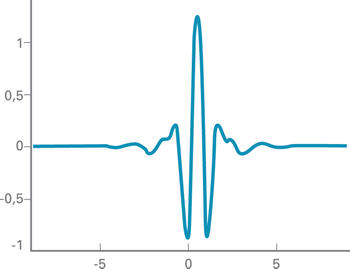

Destaquemos finalmente que otra diferencia importante con la transformada de Fourier es que existe una gran diversidad de wavelets con distintas propiedades, en contraposición con el caso de Fourier donde los átomos son solo senos y cosenos. O sea, nuestras funciones wavelet pueden ser elegidas de acuerdo con las necesidades del problema como se muestra en la figura 5.

|

|

| Figura 5. Ejemplos de diferentes wavelets: wavelet ‘spline’ y wavelet de Meyer. Ambas son bien concentradas y su gráfico no se trunca como en el caso de la wavelet de Haar mostrada en la figura 4. La wavelet de Meyer fue una de las primeras obtenidas que gozaban de propiedades de gran suavidad, lo cual la hace importante en matemática pura. La wavelet spline es menos suave, pero de duración finita lo que la hace más adecuada para las aplicaciones en ingeniería. | |

Multirresolución

Uno de los desarrollos más profundos y elegantes de la teoría de wavelets es el concepto de análisis de multirresolución. La idea central es que dada una imagen digital I0 (por ejemplo de 512 x 512 pixeles) se quiere obtener una versión de menor resolución. Esta será una imagen que se verá como la original aunque un poco desdibujada o borroneada. Técnicamente, lo que se busca es aumentar la redundancia entre los valores de los pixeles. (Queremos decir con esto que pixeles cercanos tendrán valores parecidos). La manera de hacerlo es reemplazando el valor de cada pixel por un promedio de los valores de los pixeles vecinos. La nueva imagen ha perdido información con respecto a la original. Debido a que se ha incrementado la redundancia (o sea, la diferencia de tonalidad entre un píxel y su vecino ha disminuido), parece claro que si uno desecha un píxel de cada cuatro, no se pierde información significativa. Esta nueva imagen, llamémosla I1, puede entonces ser representada usando 256 x 256 pixeles (ver figura 6).

|

|

|

|

|

Figura 6. La descomposición en wavelets. En la figura 6a se muestra la imagen de Lena Sjööblom (Miss November 1972 de la revista Playboy y cuya imagen es una de las más usadas como estándar de comparación para los métodos de compresión de imágenes). En las figuras 6b, 6c y 6d se muestran las distintas etapas de multirresolución usando la técnica de la transformada wavelet. Las imágenes van apareciendo más borrosas en los sucesivos pasos pero se va ganando en compresión. Por ejemplo, la imagen en 6d solamente requiere 1024 pixeles mientras que la original usa 262.144 pixeles. La figura 6e es la diferencia entre la original y la de menor resolución. Aquí se observan los detalles que se han perdido en la figura 6b.

|

||

¿Qué hemos perdido al pasar de la imagen inicial I0 a la I1? Uno puede imaginarse que en la imagen promediada y decimada I1, algunos detalles presentes en I0 habrán desaparecido. Supongamos que esos detalles conforman una imagen que llamamos D1. Luego supongamos por un momento que la imagen original es la superposición de la imagen promediada con la imagen que contiene los detalles, o sea I0 = I1+ D1. Entonces uno podría desechar I0 y quedarse con I1 y D1. Esto es, I0 puede ser reconstruido a partir de I1y D1. Si se aplica ese mismo procedimiento a la imagen I1, esta queda descompuesta en una imagen I2 y los detalles de nivel 2 que llamamos D2. O sea D2 representa los detalles de I1 que han desaparecido en I2. Esta nueva versión promediada I2 tiene 128 x 128 pixeles. Nuevamente podemos ahora descartar I1 y quedarnos con D1, D2 y I2. Para reconstruir la imagen original I0, solo bastaría hacer (D2+I2)+D1.

Después de 9 pasos (lo que se necesita para ir de 1 a 512 en potencias de 2) llegamos a la representación (D1, D2,…, D9, I9) a partir de la cual podría reconstruirse I0. La imagen I9 solo contiene un pixel así que puede ser desechada. De esta manera, la imagen original queda representada como la superposición de los detalles de todos los niveles.

Este procedimiento puede graficarse con el siguiente ejemplo. Pensemos que la señal original es una fotografía aérea, y la señal al doble de escala es la foto desde el doble de altura. En esta nueva foto seguramente han desaparecido detalles que corresponden al nivel de escala de la primera foto.

El problema por resolver ahora es cómo implementar este proceso. Veamos dónde está la dificultad. Uno necesita, en el primer paso, obtener los detalles D1 como diferencia de I0 e I1. Pero estas dos imágenes son de distinto tamaño por lo que no pueden restarse pixel por pixel. A principios de los años 80, Stéphane Mallat, un estudiante de origen francés que por esa época estaba realizando su tesis doctoral, intuyó que la emergente teoría de wavelets podría proveer el marco formal adecuado para realizar este proceso eficientemente. Junto con el conocido matemático francés Yves Meyer desarrollaron el concepto de Análisis de Multirresolución, una elegante teoría matemática que sienta las bases para la construcción de la mayoría de las wavelet hoy conocidas.

En el análisis de multirresolución, además de la wavelet w=w(t), hay involucrada una nueva función asociada, la función de escala v=v(t).

En la descomposición descripta anteriormente de una imagen I0 = I1+ D1, la componente D1 correspondiente a los detalles, puede ser descripta eficientemente por las traslaciones de la wavelet w. La componente I1es una versión de menor resolución de la imagen original I0. Esta componente puede ser descripta por las traslaciones de la función v.

En el siguiente paso se obtiene la descomposición I1 = I2+ D2. Aquí D2 es descripta por las traslaciones de w(t/2) e I2 por las traslaciones de v(t/2) y así sucesivamente. En otras palabras, las distintas dilataciones de la función de escala v permiten describir las distintas versiones de la imagen a distintos niveles de resolución (ver figura 6).

Cabe destacar que la implementación computacional de este proceso es muy eficiente.

AplicacionesEn esta sección describiremos solo algunas de las aplicaciones de la teoría de wavelets.

Un modelo para el sistema visual: el norteamericano David Marr, del laboratorio de inteligencia artificial del Instituto Tecnológico de Massachusetts (MIT) y un experto en el sistema visual humano, trató de explicarse en la década de 1980 el porqué de los fracasos en los intentos de construir un robot capaz de comprender su entorno visual. La teoría que Marr desarrolló se basa en que el procesamiento de imágenes en el sistema de visión humana tiene una complicada estructura jerárquica que comprende varias capas de proceso. En cada nivel de proceso el sistema de la retina provee una representación visual que trabaja de una manera progresiva cambiando de escala. Sus argumentos se basan en la detección de los cambios de intensidad. Marr sostiene que estos cambios ocurren a diferentes niveles de escala en una imagen, de forma tal que su óptima detección requiere el uso de operadores de diferentes tamaños. El operador diseñado por Marr era una wavelet hoy conocida como wavelet de Marr.

Otra aplicación interesante es la compresión de la base de datos de huellas dactilares del FBI. En 1992, el FBI eligió un método de wavelets desarrollado por Tom Hopper, de la división de Servicios de Información Criminal del FBI, y Jonathan Bradley y Chris Brislawn, del Laboratorio Nacional de Los Álamos, para comprimir su enorme base de datos de huellas dactilares. Aquí se usaron las llamadas wavelets biortogonales. Esta base de datos constaba en esa época de 30 millones de conjuntos de huellas dactilares. Cada huella dactilar digitalizada ocupa aproximadamente 0,6 Megabytes, o sea los diez dedos requieren cerca de 6 Megabytes y el archivo total aproximadamente 200 terabytes. La razón de compresión usando wavelets es aproximadamente 1:26.

En lo que respecta a imágenes, el estándar de compresión JPEG usó la llamada ‘transformada coseno local’ donde las funciones bases son cosenos truncados por una función ventana. El nuevo estándar JPEG 2000 usa en cambio wavelets.

Eliminación de ruido en grabaciones sonoras: las bases de wavelets se han utilizado en la eliminación de ruido en viejas grabaciones sonoras con éxito. En particular se han mejorado registros de 1904 del gran tenor Enrique Caruso. Por otro lado, ha podido recuperarse una grabación de Johannes Brahms de 1889 de una de sus Danzas Húngaras que estaba extremadamente dañada y de la cual solo se poseía el registro original en un cilindro de cera.

Finalmente, en aplicación al cine, en 1995 Pixar Studios presentó la película Toy Story, la primera película de dibujos animados realizada completamente por computadora. En la secuela Toy Story 2, algunas formas se realizan mediante superficies de subdivisión, una técnica relacionada matemáticamente con las wavelets.

Actualmente, hay un extraordinario interés en la teoría de wavelets

y es un área activa de investigación en todo el mundo. Ya es parte de la currícula

de la mayoría de las carreras de matemática e ingeniería de las universidades

del mundo. En nuestro país existen varios grupos que trabajan en el tema. ![]()

Deseamos agradecer a Victor Yohai por su sugerencia de escribir esta nota. A Daniel Cabrelli por la lectura cuidadosa del manuscrito y a los árbitros por sus atinados comentarios y observaciones.

|

Carlos

Cabrelli Doctor en Ciencias Matemáticas, UBA. Profesor Titular, Depto. de Matemática, FCEyN, UBA. Investigador Independiente, CONICET. Presidente de la Unión Matemática Argentina. cabrelli@dm.uba.ar - http://mate.dm.uba.ar/~cabrelli |

|

Úrsula María Molter Doctora en Ciencias Matemáticas, UBA. Profesora Titular, Depto. de Matemática, FCEyN, UBA. Investigadora Independiente, CONICET. Directora, Depto. de Matemática, FCEyN, UBA. umolter@dm.uba.ar - http://mate.dm.uba.ar/~umolter |

Lecturas sugeridas

BURKE HUBBARD B, 1998, The world according to Wavelets, the story of a mathematical technique in the making, A.K. Peters Ltd., Wellesley, Massachusetts.

GRAPS A, 1995, ‘An introduction to wavelets’, IEEE, Computational Science and Engineering 2, nro. 2.

HERNÁNDEZ E, 2003, ‘Ondículas y tecnología’, Bol. Soc. Esp. Mat. Apl., nro. 25, pp. 39-54.

STRANG G, 1994, ‘Wavelets’, American Scientist, 82, pp. 250-255.

|

| Pág.

22/31 |